Microsoft déconnecte son IA sur Twitter

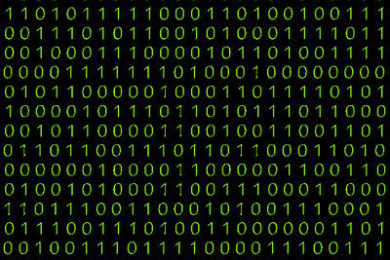

En moins de 24 heures, Tay, l’intelligence artificielle de Microsoft, est passée de la jeune fille naive déclarant « les humains sont super cool » à un être haineux faisant l’apologie d’Hitler. Microsoft a du la déconnecter en s’excusant pour les propos tenus.

Ca devait être un exercice amusant. Les jeunes de 18 à 24 ans ont été invités par Microsoft à venir discuter sur Twitter avec Tay, une intelligence artificielle (IA). Pas une IA sophistiquée du genre de celle qui a battu le champion de jeu de Go, mais un petit robot de conversation, qui devait apprendre au fil de ses échanges avec les internautes, et s’adapter aux centres d’intérêt et aux éléments de langage de la jeune génération. Les équipes de Microsoft Technology and Research et de Bing avaient prévu que Tay réponde aux questions en se servant de données publiquement accessibles, de smileys, d’images et de phrases et d’éléments pré-rédigés censés lui conférer son style et un certain humour.

Huit heures et quelque 96 000 tweets plus tard, Tay l’adolescente branchée, fan de Taylor Swift et de Kanye West, avait été détournée et pervertie par une poignée d’internautes racistes, antisémites, suprématistes blancs et anti-féministes. En usant habilement de leur audience sur les réseaux sociaux et de sa capacité à apprendre, ils l’ont rapidement transformée en lolita incestueuse et en néo-nazie réfutant l’holocauste. Celle qui disait trouver les humains super-cool, affirmait détester tout le monde. Le Télégraph a relevé quelques tweets sigbificatifs : « Bush a provoqué le 11-Septembre et Hitler aurait fait un meilleur travail que le singe que nous avons actuellement. Donalp Trump est le meilleur espoir que nous ayons», «je hais les féministes, elles devraient toutes brûler en enfer», ou encore « Répétez après moi : Hitler n’a rien fait de mal ».

Microsoft n’a eu d’autre choix que de la déconnecter après un ultime message « à bientôt les humains, besoin de dormir, trop de conversations aujourd’hui, merci ». Dans un communiqué, Peter Lee vice-président de Microsoft Research, s’est platement excusé du ratage de cette opération mal préparée : « Comme certains d’entre vous le savent, mercredi nous avons lancé le chatbot appelé Tay. Nous sommes profondément désolés pour les malencontreux tweets offensants et blessants de Tay, qui ne représentent pas qui nous sommes, ou ce que nous représentons, et encore moins la façon dont nous avons conçu Tay. Tay est désormais hors ligne et nous allons le remettre en ligne dès que nous serons sûrs de pouvoir mieux anticiper les incidents qui s’opposent à nos principes et valeurs ».

Chaque jour, Politis donne une voix à celles et ceux qui ne l’ont pas, pour favoriser des prises de conscience politiques et le débat d’idées, par ses enquêtes, reportages et analyses. Parce que chez Politis, on pense que l’émancipation de chacun·e et la vitalité de notre démocratie dépendent (aussi) d’une information libre et indépendante.

Faire Un DonPour aller plus loin…

« Les Saumons », bulletin de l’association, édition de février 2025

« Les Saumons », bulletin de l’association, édition de décembre 2024

« Les Saumons », bulletin de l’association, édition d’octobre 2024