« Une intelligence artificielle de confiance doit être socialement acceptable »

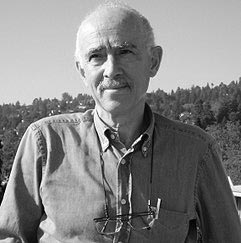

Malik Ghallab est un chercheur du CNRS spécialiste de l’intelligence artificielle. Il revient sur les enjeux sociétaux qui gravitent autour de l’IA qui, plus qu’une simple technologie, est un véritable domaine scientifique à part entière.

dans l’hebdo N° 1800 Acheter ce numéro

© Cash Macanaya / Unsplash.

Dans le même dossier…

L’intelligence artificielle contre la fraude fiscale ? Comment l’intelligence artificielle a déjà changé la guerre Les errements sexistes de l’intelligence artificielle ChatGPT : ne pas se tromper d’inquiétudeL’imaginaire qui gravite autour de l’intelligence artificielle nourrit une multitude de fantasmes. En 2023, l’arrivée de ChatGPT dans les usages quotidiens a montré aux sociétés la puissance de l’IA générative et les potentielles mutations qu’elle pourrait entraîner : certaines professions seront-elles remplacées ? Les usages de l’IA générative sont-ils illimités ? Comment encadrer le développement de cet outil ? Malik Ghallab, ancien directeur du Laboratoire d’analyse et d’architecture des systèmes au CNRS (LAAS-CNRS à Toulouse), apporte un éclairage scientifique à ces questionnements.

Aujourd’hui, les usages de l’IA générative sont-ils illimités ?

Malik Ghallab : Dans le domaine de la science, on peut dire que les usages sont quasiment illimités. À partir du moment où vous essayez de comprendre, vous devez modéliser. Peu importe le domaine scientifique, vous avez besoin de données, de comprendre les données que vous avez à interpréter, vous avez besoin de construire des modèles. Et, aujourd’hui, on ne sait pas faire ça aussi bien qu’avec des machines – on est largement dépassé à la main ou à l’œil nu. Et avec les machines, on ne le fait qu’avec des techniques d’IA. Aujourd’hui, je pense qu’il n’existe pas un seul domaine scientifique dont le progrès ne soit pas tributaire des techniques d’IA.

Tout ce qui touche la science aujourd’hui est impacté par l’intelligence artificielle.

Elle est quasiment devenue monnaie courante : les techniques de base pour calculer un écoulement, la technique de base de prédiction météo, les modèles de base de ce qu’est le système cardiovasculaire… tout cela est modélisé aujourd’hui avec des techniques IA. Il existe des modèles qui conjuguent tout cela dans des systèmes que le médecin peut interroger par réalité virtuelle. Je pense donc que tout ce qui touche la science aujourd’hui est impacté par l’intelligence artificielle. Mais, dans la vie de tous les jours, c’est une autre affaire, car le savoir scientifique n’est pas nécessairement d’un usage quotidien.

Y a-t-il un risque de voir l’intelligence artificielle se substituer à la force humaine dans certains secteurs d’activité ?

On sait mécaniser des métiers essentiellement manuels et extrêmement répétitifs. Un robot qui fonctionne 24 heures sur 24, 7 jours sur 7 et 365 jours par an, dans une chaîne d’industrie manufacturière, coûte environ l’équivalent du salaire de six mois de travail d’ouvriers spécialisés. Donc les incitations sont fortes. Des tâches qui nécessitent essentiellement du traitement de données, comme pour des dossiers de Sécurité sociale ou des dossiers bancaires, sont aussi largement mécanisables aujourd’hui.

Est-ce que cela va être fait, pour autant ? D’autres considérations priment, des considérations d’ordre économique, mais aussi des considérations d’ordre social. Quand il s’agit de prendre des décisions qui impliquent des humains, il faut avoir une perception de la personne qui est derrière. Ce n’est pas qu’un dossier abstrait, il y a donc fort heureusement des freins de nature éthique, qui font qu’on ne devrait pas déléguer ce type de décision à l’IA.

Prenons l’exemple de la médecine. Dans un certain nombre de domaines, l’IA va être indispensable au médecin. Elle ne pourra cependant pas le remplacer. Mon médecin traitant va avoir une perception humaine de mon état physique. Le son de ma voix, mon visage, mes attitudes… Tout cela ne relève pas de données formelles qu’on va donner à la machine. Aux États-Unis, au Brésil et en Pologne, on est arrivé à faire passer aux systèmes d’IA générative des examens finaux du diplôme de médecine. Les succès vont au-delà de 80 % de réponses justes. Mais l’IA ferait-elle un bon médecin ? Non, car elle ne dispose pas de cette perception humaine essentielle dans de nombreux corps de métiers, dont la médecine.

L’IA ferait-elle un bon médecin ? Non, car elle ne dispose pas de cette perception humaine essentielle.

En revanche, l’IA permet à la médecine de devenir très précise. Une machine est capable d’analyser 30 000 images d’un scanner en peu de temps. Dans le cas des tumeurs du foie, il arrive de façon relativement fréquente, malheureusement, que l’on passe à côté de la détection d’une petite tumeur, parce que les coupes que le radiologue a examinées étaient trop espacées et qu’il n’avait que vingt minutes pour examiner le cas.

Une machine va être capable d’analyser plus de données pour éventuellement détecter un soupçon. Encore plus loin que ça, on est capable d’anticiper le développement d’un certain nombre de pathologies. On est capable de dire qu’une imagerie cérébrale peut probablement correspondre à un patient qui va développer Alzheimer dans deux ans, et qu’il vaut mieux anticiper un traitement préventif.

Vous avez soulevé la question des enjeux éthiques. Comment légiférer le secteur de l’IA pour mieux encadrer ses usages et son développement ?

Pour bien légiférer, il faut disposer d’une bonne compréhension scientifique de nos capacités techniques. L’un des défis est d’expliquer, de bien comprendre et de maîtriser les capacités techniques que nous savons programmer. Quand on regarde ce qui peut être fait, par exemple, par ChatGPT, on obtient des performances remarquables, mais on est ensuite obligé de les brider. On fait cela de façon relativement ad hoc par diverses méthodes d’apprentissage par renforcement sur des annotations humaines. La démarche est empirique et ne s’appuie pas sur une caractérisation précise sur ce que ChatGPT a appris ou peut faire.

Aujourd’hui, l’« AI Act » européen est un très bon pas vers la régulation de l’IA, puisqu’il se décline sous forme de niveaux de sécurité ou de risque, plus ou moins importants. Pour en venir aux questions éthiques, nous devons être en mesure de tout comprendre, afin de catégoriser les enjeux dans les différents niveaux de risque. On se doit de proposer une bonne compréhension de ces capacités émergentes de manière à pouvoir garantir un lien de confiance.

Une IA de confiance, c’est une IA socialement acceptable. Mais l’acceptabilité sociale et l’acceptabilité individuelle ne sont pas identiques ! L’acceptabilité sociale est liée au respect d’un certain nombre de valeurs, dans le long terme. De son côté, l’acceptabilité individuelle est liée au plaisir et à la consommation immédiate d’un service. L’acceptabilité sociale se pense en regard de la prochaine génération. Elle doit prendre en compte les normes et les valeurs éthiques auxquelles nous adhérons tous.

De mon point de vue, il n’y a pas seulement des questions liées à l’éthique individuelle, il y a aussi des questions liées à une éthique sociale, comme la valeur travail, à la manière dont nous voulons servir à la société. Si les individus se sentent superflus vis-à-vis des machines et des outils d’IA, on touche à la cohésion sociale et on risque d’aller au-devant d’énormes risques sociaux.

Si les individus se sentent superflus vis-à-vis des machines et des outils d’IA, on touche à la cohésion sociale.

Il y a aussi d’autres risques, comme la question de la frugalité : l’IA consomme des ressources considérables et il faut faire en sorte que cet usage de ressources extrêmement dommageables pour le réchauffement climatique et la pollution soit restreint. D’une manière générale, le numérique représente 5 % de la totalité des émissions de gaz à effet de serre. Et l’intelligence artificielle contribue significativement à cette part des émissions.

Derrière la société fondatrice de ChatGPT, Open AI, se trouve Sam Altman. Ce dernier a une vision politique d’une société de loisirs, avec un revenu universel, et où la force de travail ne serait quasiment gérée que par l’intelligence artificielle. Est-ce envisageable ?

Il faudrait des transformations sociales très profondes. C’est une vision un peu utopique, non pas compte tenu de la technique, mais de l’organisation sociale. La technique a des bons et des mauvais côtés, mais elle n’est jamais neutre. Les visées libertaires et extrêmement généreuses d’OpenAI, on les a connues auparavant avec Google : offrir des technologies qui arrangent la vie des uns et des autres, quasiment gratuites. Mais on s’est vite rendu compte que derrière, il y a des règles du jeu qui sont celles du monde libéral. Sam Altman peut mettre en avant une vision qui apparaît généreuse, mais quid de sa mise en œuvre ? Regardez simplement les difficultés rencontrées pour parler de la semaine de quatre jours, alors que nous en avons largement les moyens.

Je voudrais aussi souligner que ces visions idéologiques peuvent cacher des dérives extrêmement pernicieuses. Par exemple, tout ce qui touche à l’homme augmenté et au transhumanisme, avec les centaines de millions de dollars investis dans des entreprises telle que Neuralink d’Elon Musk. Vouloir vivre plusieurs siècles est un projet d’une absurdité sans nom. Un calcul très rapide va montrer qu’avant que j’arrive à trois siècles, nous serions 300 milliards sur une planète aux ressources limitées. Quel sens à cela ? Si nous voulons nous placer dans une vision beaucoup plus durable de l’espèce humaine sur la planète, ce n’est pas nécessairement dans ce type de direction qu’il faut investir le plus.

La société ne peut pas avoir une image de l’IA qui corresponde à la réalité, parce qu’elle a besoin de trois générations pour s’adapter

L’imaginaire global de la société sur l’intelligence artificielle correspond-il à la réalité ?

Non, je ne crois pas. Ce n’est pas spécifique à l’IA, je pense que tout ce qui touche la technologie peut être vu à travers une lentille déformante. Il y a aussi le fait que les publicitaires sont très forts pour vendre et véhiculer des discours qui ne correspondent pas à la réalité. Le dernier point, c’est que notre éducation et notre formation n’ont pas été adaptées à ces évolutions. Dans les années 1980, on parlait d’alphabétisation numérique, pour que quelqu’un qui sorte du système académique sache maîtriser le système numérique – faire une recherche sur Internet, utiliser un traitement de texte ou un tableur.

Aujourd’hui, nous n’avons pas besoin d’une alphabétisation numérique, mais d’une alphabétisation sur l’IA, que nous n’avons pas encore développée. Il faut comprendre ce qui se trouve derrière un moteur de recherche, comprendre les heuristiques qu’il recèle, comprendre quels critères sont mis en avant pour privilégier la réponse A plutôt que la réponse B. Et il aurait fallu le faire depuis vingt ans, dès le plus jeune âge. Donc non, la société ne peut pas avoir une image de l’IA qui corresponde à la réalité, parce qu’elle a besoin de trois générations pour s’adapter : une génération qui développe une technique, une qui l’enseigne et une qui la maîtrise. Nous sommes encore à la première génération.

Pour aller plus loin…

Tour de France : Franck Ferrand, commentateur réac’ toujours en selle

La CGT et le Tour de France : quand sport et luttes se marient bien

« Ils parlent d’échange de migrants comme si les personnes étaient des objets »